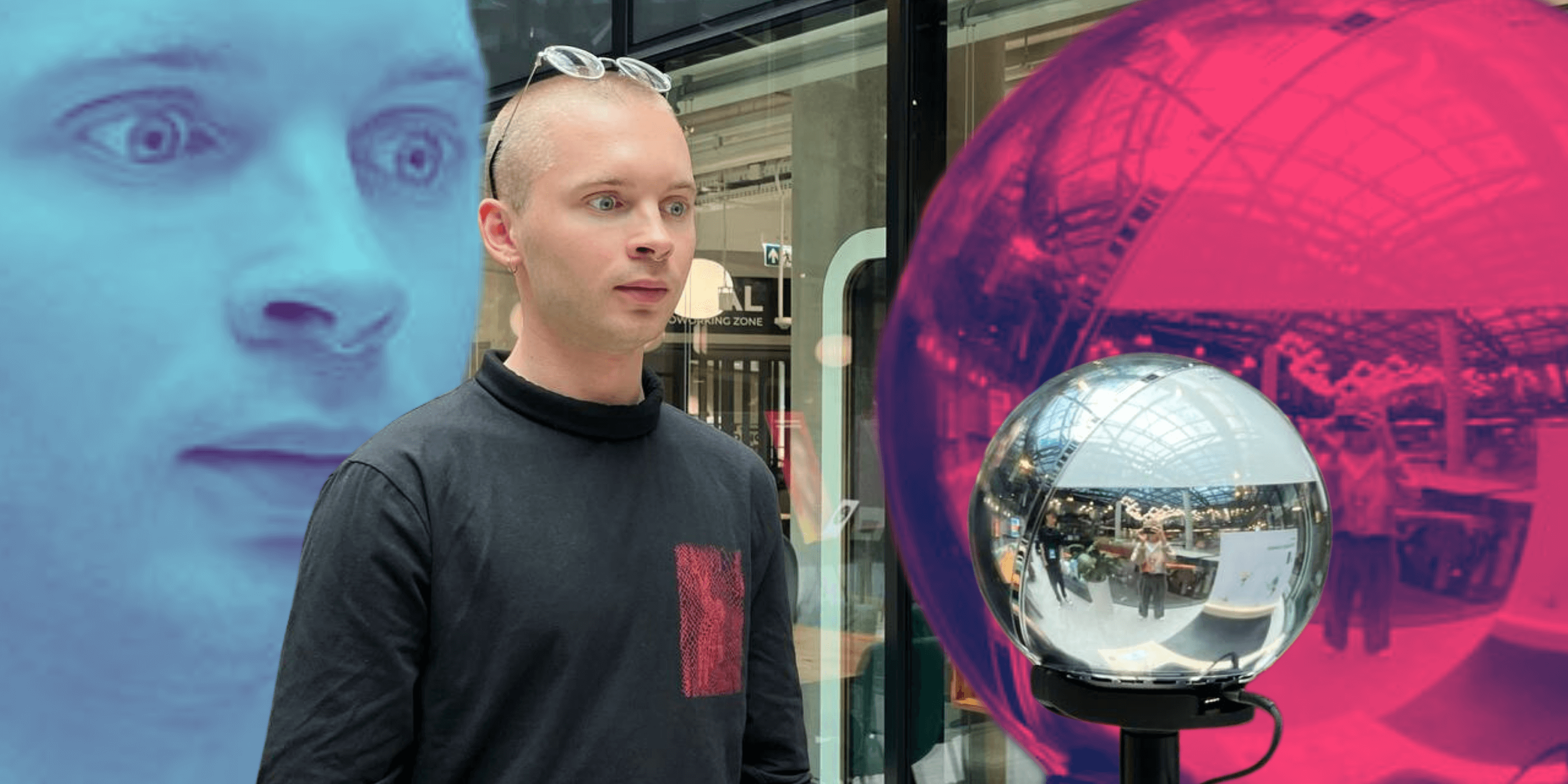

“Czytanie w internecie doprowadza mnie do furii.” – mówi Wojciech Mann w rozmowie z Krzysztofem Stanowskim na Kanale Zero. “Czytam tytuł: «Pies ugryzł strażaka». Zaciekawiło mnie to, pytam Dlaczego? A dalej najpierw biografia psa, potem biografia strażaka, potem czy strażacy mają psy i czy psy lubią strażaków. Jak już dochodzę do samego końca, na dole jest napisane «I w końcu ten pies ugryzł strażaka».”

Każdy z nas doświadczył tego, co Mann. Nie dowiesz się jak ugotować ziemniaki, dopóki nie poznasz etymologii słowa “pyry” i nie ustalisz, czy twój wymarzony telefon jest wodoodporny, aż nie przeczytasz omówienia standardów wodoszczelności.

“Nie wiem czy chodzi o to scrollowanie, czy o klikalność,” – kontynuuje Mann. “ale to nie ma nic wspólnego z dziennikarstwem.” Może znany radiowiec nie należy do pokolenia cyfrowych tubylców, ale jego intuicja go nie myli.

Tak – chodzi o klikalność, nie – nie ma to wiele wspólnego z dziennikarstwem.

Za rozwlekłe teksty, pełne “fraz kluczowych” i “wewnętrznych odnośników” najczęściej odpowiedzialni są copywriterzy oraz specjaliści SEO, a ich naczelnym zadaniem jest, aby strona znalazła się jak najwyżej w wynikach wyszukiwania. Jednak w prowadzonym przez nich wyścigu o pierwsze miejsce w wyszukiwarce Google, przegrywamy my – odbiorcy.

Na początku był chaos

“Internet rozwija się w piorunującym tempie” – pisał włoski naukowiec Massimo Marchiori w 1997 roku. “Eksplozja w ilości zarówno hostów, jak i osób korzystających z sieci, sprawiła, że kluczowy stał się problem zarządzania tak ogromną ilością informacji. Aby przetrwać w tej informacyjnej dżungli, użytkownicy sieci muszą polegać niemal wyłącznie na wyszukiwarkach.”

W pracy Szukając prawdziwych informacji w sieci: Hiperwyszukiwarki Marchiori opisywał zjawisko tzw. SEP (Search Engine Persuasion), polegające na dostosowywaniu stron do wymagań stawianych przez wyszukiwarki. “Są one tak ważne na rynku reklamowym, że dla firm niezbędne stało się, żeby ich strona figurowała na samym szczycie wyników wyszukiwania.” Marchiori nie pisał jednak o wyszukiwarce Google, która powstała dopiero rok po jego publikacji. Do tego czasu korzystano z takich systemów, jak WebCrawler, Excite czy Magellan.

Tym, co pozwoliło Google’owi niemal natychmiast przejąć pozycję lidera branży, był algorytm porządkujący wyniki wyszukiwania. Dotychczas skupiały się one jedynie na ilości powtórzenia wyszukiwanej frazy na stronie, jednak system o nazwie PageRank (od web page, ale też w nawiązaniu do nazwiska jego autora, Larrego Page’a) dodatkowo liczył ilość linków prowadzących z innych portali, do danej strony, oceniając według tego jej rangę.

Od 1998 system rankingu stron został rozbudowany o setki czynników. Równocześnie wzrosły oczekiwania firm, dla których wyższa pozycja w wynikach wyszukiwania Google stała się podstawową formą dotarcia do klientek. W odpowiedzi na to zapotrzebowanie powstało SEO (Search Engine Optimisation): sztuka dostosowywania stron internetowych do oczekiwań algorytmów wyszukiwarek.

Cyfrowe Eldorado i potworki Google’a

Nasz kontakt z internetem jest niemal zawsze pośredniczony przez wyszukiwarkę. W pasku URL nie wpisujemy adresu danej strony (youtube.com), a raczej jej nazwę (YouTube), która przenosi nas do wyników wyszukiwania. Ten przykład jest istotny, ponieważ fraza “YouTube” jest obecnie najczęściej wyszukiwanym hasłem w Google. Rolę wyszukiwarki, jako pośrednika naszych kontaktów z internetem, potwierdza pozycja frazy “Google” w rankingu wyszukiwanych haseł. Zajmuje ona obecnie piąte miejsce, z ponad 83 mln wyszukań w tym roku.

Konieczność optymalizacji treści działa ze szkodą dla użytkowników. Strony internetowe wyglądają podobnie, a publikowane na nich teksty nie są kierowane do czytelników a do szperaczy Google’a.

SEO, podobnie jak opisywane przez Marchioriego SEP, ma na celu promocję strony w wynikach Google. Siermiężne powtarzanie popularnej frazy we wpisie na blogu, praktykowane w latach 90., nie ma jednak wiele wspólnego z optymalizacją współczesnych portali. Obecnie algorytm Google’a stosuje takie wskaźniki, jak długość zdań i akapitów czy obecność słów łączących w tekście (takich, jak “ponieważ”, “dlatego”, “w rezultacie”). Jednak nie wszystkie z tych wytycznych są jawne.

– Google nie może wszystkiego powiedzieć. Gdyby ujawnił wszystkie warunki, to by się zaczęło Eldorado – mówi mi Dominik Fajferek, Head of SEO w agencji SEM House. – Gdyby jasno powiedzieli, że linki wpływają na autorytet strony, to wszyscy zaczęliby tylko kupować linki, a Google chce, żeby one stanowiły zwykłe polecenie, bez elementu sprzedaży czy sponsoringu.

Specjaliści SEO w oparciu o wskazówki dostarczane przez Google oraz metodą prób i błędów znajdują sposoby na oszukanie algorytmu wyszukiwania. Stają się one powszechnie znane, a strony są coraz agresywniej optymalizowane, żeby wybiły się przed portalami o podobnej tematyce.

– Dlatego powstają takie potworki na wiele tysięcy znaków, które dla czytelnika nie mają zbyt wiele sensu – komentuje Fajferek.

Konieczność optymalizacji treści działa ze szkodą dla użytkowników. Strony internetowe zaczęły wyglądać bardzo podobnie, a publikowane na nich teksty przestały być kierowane do czytelników a do tzw. szperaczy Google’a, które sprawdzają parametry portalu. W konsekwencji niemal każdy element internetu – od nagłówków, aż po URL, został albo zoptymalizowany, albo zepchnięty na dalszą stronę wyszukiwarki, czyli poza krawędź internetu.

Problem obniżenia jakości treści w wyniku optymalizacji nie jest nowy. “Sztuczne zwiększanie ilości tekstu doprowadziło do znacznego pogorszenia wydajności wyszukiwarek” – pisał w 1997 Marchiori. “Sytuacja staje się coraz gorsza, ponieważ opracowywane są coraz bardziej wyrafinowane techniki analizy wyszukiwarek i dostosowania pod nie stron.” W ponad dwie dekady od publikacji tekstu przez włoskiego badacza, proces ten postępował.

– SEO bardzo negatywnie wpłynęło na jakość treści w internecie – mówi mi Stanisław Bryś, sekretarz redakcji Going. MORE oraz dziennikarz współpracujący z portalami newonce i NOIZZ. – Mam wrażenie, że w pogoni za zyskiem niektóre portale przeginają i w pewnym momencie zaczynają przypominać informacyjny śmietnik, który nie niesie żadnej wartości dla czytelników. News, który można przekazać w 20 słowach, ze względu na wymogi SEO staje się potworkiem na 400 słów. Ta sama wiadomość jest w nim powielona kilka razy i poprzedzona przydługim wstępem, który w rzeczywistości nie interesuje nikogo poza reklamodawcami.

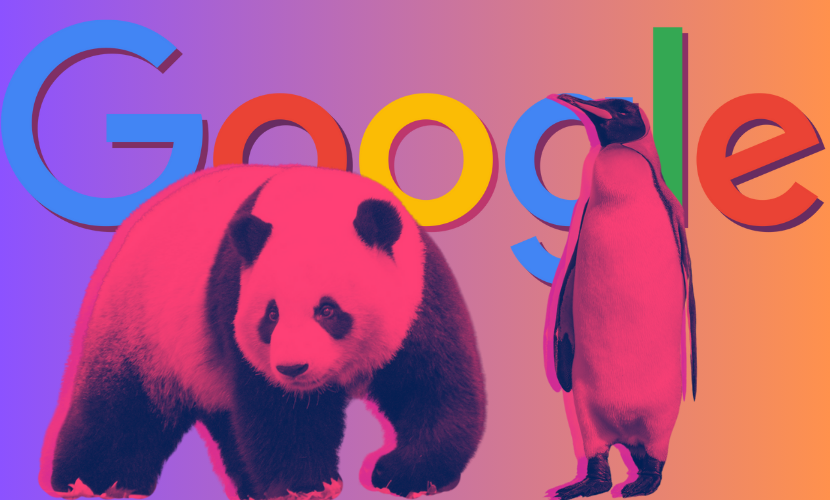

Panda i Pingwin

Google i agencje pokroju SEM House od lat prowadzą grę w kotka i myszkę. W odpowiedzi na nadmierną optymalizację, Google wprowadza modyfikacje swojego algorytmu. Aktualizacja o nazwie Panda, wprowadzona na początku 2011 roku, miała ukrócić praktykę tzw. content farms – portali, które tworzyły tysiące wpisów dziennie, optymalizowanych pod kątem wyników wyszukiwania. Wprowadzona rok później aktualizacja o nazwie Pingwin walczyła natomiast z praktyką generowania linków prowadzących do naszej strony, w celu zwiększenia jej rankingu.

Kolejne zmiany w algorytmie potrafią wyznaczyć początek nowej epoki SEO, w której obowiązują inne kryteria optymalizacji. Najnowsza aktualizacja na skalę Pandy i Pingwina miała miejsce w marcu tego roku. Dotyczyła ona stron o niskiej jakości dla odbiorców, na które dodawano wpisy masowo, dopasowując je do popularnych zapytań (jak np. “Taylor Swift” albo “Finał Super Bowl”). Ostatnia aktualizacja stanowi krok w kierunku wprowadzania sztucznej inteligencji do silników wyszukiwania.

– Wcześniej AI było kategorycznie zabronione. Teraz na stronach mogą pojawiać się wygenerowane treści, o ile są one wartościowe dla użytkownika i są zgodne z jego intencją wyszukiwania – tłumaczy mi Dominik Fajferek. – Wchodzimy w epokę SEO, w której większe znaczenie będzie miało search generative experience.

– Co to znaczy?

– Odpowiedzi będą podawane bezpośrednio przez wyszukiwarkę, a nie znajdowane na konkretnych stronach. Gdy użytkownik zada proste pytanie, dostanie na nie odpowiedź. Nie będzie musiał jej samodzielnie szukać.

Czytaj: Czy AI zastąpi yutuberów? Rozmowa z Rafałem Masnym

W pasku wyszukiwania nie będziemy wpisywać haseł, a pytania. Pierwszym wynikiem będzie odpowiedź sztucznej inteligencji wraz z linkami do źródeł. Nowym zadaniem specjalistów SEO będzie sprawić, żeby nasza strona była jednym z tych linków.

To nie pierwszy raz, gdy postęp technologiczny wpłynął na zasady optymalizacji, czyli także na kształt treści publikowanych w internecie. W 2015 roku, kiedy smartfony były już dominującą formą korzystania z internetu, Google przeprowadził kolejną aktualizację algorytmu nazywaną w środowisku specjalistów SEO Mobilegedonem. Od tego momentu wyszukiwarka preferowała portale dostosowane do wyświetlania na telefonach, obniżając ranking stron nie posiadających wersji mobilnej.

Kolejna epoka SEO ma stanowić odpowiedź na rozwój sztucznej inteligencji.

“Dzięki systemom generatywnego AI, możemy skrócić proces wyszukiwania, dzięki czemu będziesz mógł szybciej zrozumieć dany temat, odkryć nowe punkty widzenia i sprawniej załatwiać sprawy” – pisze Elizabeth Reid, która zanim w marcu tego roku objęła stanowisko szefowej działu wyszukiwania Google, przewodziła zespołowi platformy odpowiedzialnemu za search generative experience.

Obecnie przypadki optymalizacji widzimy nawet w świecie rzeczywistym. Przykładem są restauracje pod szyldem “Near me”, których nazwa pojawi się wyżej w wynikach wyszukiwania, kiedy będziemy szukali jedzenia w okolicy.

– SEO bardzo silnie wpłynęło na modele językowe – mówi Dominik Fajferek. – Sztuczna inteligencja została zbudowana na treściach dostępnych w internecie, które są zoptymalizowane pod kątem wyszukiwarek. Dlatego m.in. nie poda odpowiedzi od razu, tylko najpierw obejdzie temat dookoła.

Reżim SEO

Stworzenie w 1998 roku technologii PageRank możemy uznać za początek ery algorytmizacji. Obecnie podporządkowanie systemowi sortowania treści znajdziemy we wszystkich zakątkach sieci. “To od algorytmów zależy, jakie strony internetowe znajdziemy w wynikach wyszukiwania Google, jakie storiesy obejrzymy na Facebooku, jakie utwory odtworzy nasz Spotify, jakie osoby wyświetlą się nam jako potencjalne matche w aplikacjach randkowych, jakie filmy będą polecane na stronie głównej Netflixa. To algorytm personalizuje strumień filmików na TikToku i ustala kolejność postów na Twitterze czy Instagramie, a nawet decyduje do jakich folderów trafią nasze e-maile; to on wyświetla reklamy, które widzimy na każdym kroku” – wymienia Kyle Chayka w tekście Filterworld: How Algorithms Flattened Culture.

Algorytmy prowadzą kuratelę nie tylko nad informacjami, jakie zdobywamy w internecie, ale nad całą kulturą, jaką konsumujemy. Obecnie przypadki optymalizacji widzimy również w świecie rzeczywistym. Karykaturalnym przykładem będą restauracje pod szyldem “Near me”, których nazwa ma sprawić, że pojawią się wyżej w wynikach wyszukiwania, jak tylko będziemy szukali jedzenia w okolicy.

Optymalizujemy tytuły książek, żeby wyskakiwały wyżej w wyszukiwaniach na Amazonie i wygląd kawiarni, które zbiorą więcej lajków pod zdjęciem na Instagramie. Algorytmowi podporządkowują się całe miasta, jak chociażby włoskie Portofino, które po tym, jak stało się viralem w mediach społecznościowych, musiało wprowadzić serię obostrzeń walczących z zalewem turystów. Optymalizacja wpływa również na nasz język, do którego coraz silniej przedzierają się internetowe trendy, co widzimy na przykładzie spopularyzowania terminów, takich jak “hunter eyes” (kształt oczu, rzekomo odróżniający “mężczyzn-drapieżników” od “mężczyzn-ofiar”) czy “black pill” (zbiorcze określenie ideologii), zaczerpniętych ze środowiska inceli.

W konsekwencji algorytm wpływa na nasze umysły: nasze poglądy, nasz gust. Od ponad dwóch dekad widzimy postępującą seofikację naszego świata i nic nie wskazuje, żeby w najbliższym czasie ten trend miał ulec zmianie. W końcu, jak ujął to Kyle Chayka – “Algorytm zawsze wygrywa.”

Porządkowanie świata

Czy to źle, że algorytmizacja jest coraz wyraźniej dostrzegalna w naszej kulturze? Chayka powiedziałby, że tak. Seofikacja prowadzi do opisywanego przez niego “spłaszczenia” kultury, która zaczyna opierać się na powielanych wzorcach. Treści publikowane w internecie i dostosowywane pod algorytm produkty są nie tylko podobne, ale i przestają być tworzone z myślą o odbiorczyniach.

Równocześnie Google zdaje się mówić, że nie potrzebujemy mniej algorytmu, ale więcej.

Kolejne aktualizacje wprowadzane do przeglądarki, mają na celu promocję organicznych treści, tworzonych przez i z myślą o człowieku. Obecny algorytm stara się np. faworyzować różnorodne materiały.

– Google promuje newsy przedstawiane z różnych perspektyw, które mogą trafić do kilku baniek informacyjnych i zostać wyszukane przez odmienne frazy – mówi Dominik Fajferek.

Ilość informacji umieszczanych w internecie musi przechodzić przez system weryfikacji i porządkowania. Problem pojawia się, gdy zasady tego systemu są wyznaczane przez prywatną firmę, zależną od swoich akcjonariuszy.

– Czy faktycznie musimy wybrać czy nasz tekst będzie wartościowy, czy spodoba się algorytmom wyszukiwania? – pytam dziennikarza Stanisława Brysia.

– Nie chcę powiedzieć, że te rzeczy się w pełni wykluczają, ale pogodzenie ich to trudne zadanie, zwłaszcza jeśli chcesz równocześnie dbać o wartość merytoryczną i językową tekstu, a do tego zaskoczyć czytelnika. Powstaje jednak pytanie, czy powinniśmy się podporządkowywać dyktatowi wyszukiwarek. Jedną z fundamentalnych wartości dziennikarstwa jest jego niezależność. Tymczasem okazuje się, że musimy działać według zasad technologicznego giganta: albo się do nich dopasujesz, albo znikasz.

Kolos na glinianych nogach

Ogłoszony w maju na ostatniej konferencji Google I/O system automatycznego generowania odpowiedzi AI Overview okazał się fiaskiem. Następca Search Generative Experience, powołując się na shitposty z Reddita i publikacje satyrycznego pisma Onion zaczął sugerować użytkownikom Google jedzenie kamieni i dodawanie kleju do pizzy. Mimo tych wpadek dalej powinniśmy zakładać, że przyszłość korzystania z internetu będzie bazowała na generatywnej sztucznej inteligencji.

“To będzie miało katastrofalne skutki dla ruchu na naszej stronie” – mówi Danielle Coffey, dyrektor generalny News/Media Alliance. “Google wykorzysta je do odpowiedzi na zapytania użytkowników, co tym bardziej ograniczy powody do kliknięcia w link, co do tej pory umożliwiało nam monetyzację treści.”

W tym samym momencie ujawniono wyciek tajnych dokumentów firmy, dotyczących mechanizmu porządkowania treści w wyszukiwaniach. Z zawartych w nim danych wynika, że firma nie tylko wykorzystuje w tym celu dane z wyszukiwarki Google Chrome, ale również, że wykorzystuje dane o autorach postów. Przedstawiciele Google wielokrotnie powtarzali, że nie stosują tych wskaźników do pozycjonowania treści.

“Kłamstwo to mocne słowo, ale w tym przypadku jest jak najbardziej adekwatne” – pisze o wycieku dokumentów Google Mike King, specjalista od SEO. „Chociaż nie winię przedstawicieli Google za ochronę zastrzeżonych informacji, nie zgadzam się z ich wysiłkami mającymi na celu dyskredytację osób ze świata marketingu, technologii i dziennikarstwa, które przedstawiały światu swoje odkrycia”.

W obliczu tych wydarzeń niektórzy komentatorzy ogłosili “śmierć SEO”, a inni “koniec pewnej ery internetu”. W końcu algorytm Google’a porządkuje sieć, na której w trakcie ostatnich dwóch dekad oparliśmy współczesną kulturę. Co się stanie, gdy nagle zmienią się jego zasady?